12月8日 消息:近年来,多模态大语言模型在自然语言处理、视觉理解和机器人领域取得了显著进展。然而,这些模型主要基于二维图片和文本数据,对于理解和交互于三维世界的任务存在一定的欠缺。为解决这一问题,北京通用人工智能研究院携手北京大学、卡耐基梅隆大学和清华大学的研究人员,提出了具备感知、推理、规划、行动等多任务多模态能力的首个三维世界具身通才智能体LEO。

论文链接:https://arxiv.org/abs/2311.12871

项目主页:https://embodied-generalist.github.io/

代码链接:https://github.com/embodied-generalist/embodied-generalist

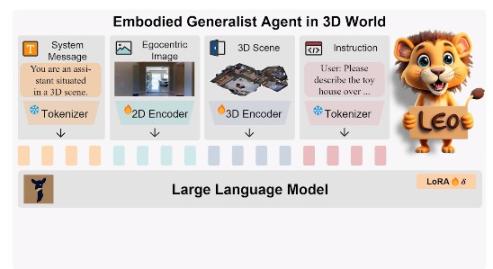

LEO的核心设计思想是以大语言模型为基础,在两个关键阶段进行训练:三维视觉-语言对齐和视觉-语言-动作指令微调。通过采用共享的架构和权重,LEO能够在不同任务之间实现无缝切换,构建了一个统一的处理框架。在数据集的收集方面,研究团队通过两阶段训练策略,包括物体级别和场景级别的大规模数据集,为LEO的训练提供了坚实基础。

研究的主要贡献体现在三个方面:首先,构建了在三维世界中完成感知、定位、推理、规划和动作执行的LEO。其次,提出了高效的学习策略,通过将以物体为中心的三维表征与语言模型相结合,成功打通了视觉-语言-动作的通道。最后,研发了生成高质量三维视觉语言数据的方法,构建了大规模的视觉-语言-动作指令微调数据集。

LEO的应用前景广泛,作为未来的家庭助理,它能够与人进行交互,调整家居布局、帮助找到物品、提供各种问题的建议。在导航和操控能力方面,LEO可应用于购物中心的智能引导、家居自动化任务以及物流中心的物品整理和搬运,展现出巨大的应用价值。

LEO的出现标志着具身通才智能体在三维世界任务上取得了新的突破,为实现通用人工智能迈出了重要一步。

![[发布于2024/11/17]长期可用免费V2ray订阅+获取地址](https://www.ceacer.cn/zb_users/theme/aymthirteen/style/images/no-image.jpg)

评论留言